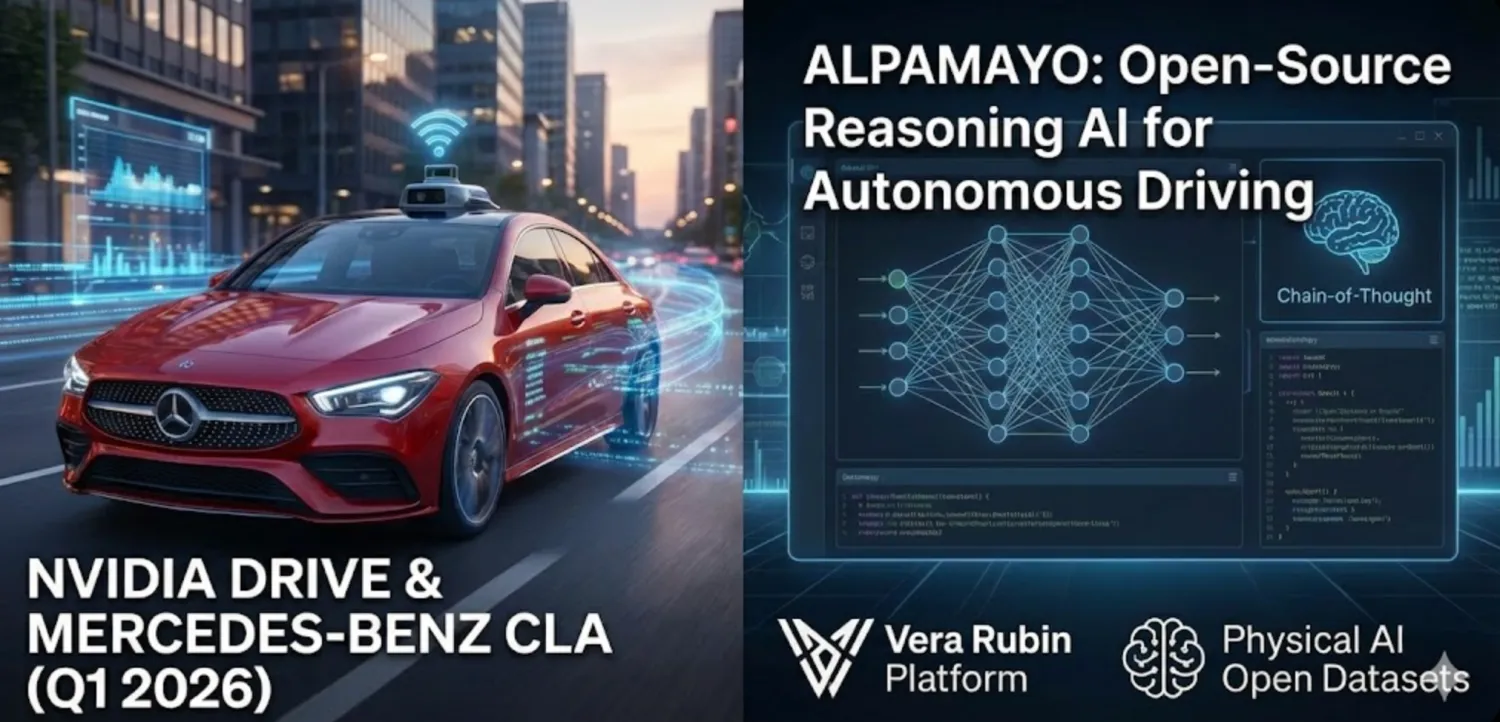

NVIDIA ha svelato un’Intelligenza Artificiale open-source capace non solo di “vedere” la strada, ma di ragionare sulle situazioni più complesse. La nuova famiglia di modelli Alpamayo promette di affrontare i casi limite che mettono in crisi i sistemi ADAS tradizionali e farà il suo debutto commerciale sulla Mercedes-Benz CLA.

I primi veicoli muniti di questa nuova tecnologia sono in arrivo nel primo trimestre di quest’anno negli Stati Uniti e poco dopo in Europa. L’annuncio della discesa in campo del leader mondiale del computing segna un passaggio strategico per l’ecosistema dell’automotive intelligente.

Una IA che “ragiona” in strada

Con Alpamayo, NVIDIA parla apertamente di un “ChatGPT moment per la Physical AI”. Il cuore dell’annuncio è Alpamayo 1, un modello Vision-Language-Action da 10 miliardi di parametri progettato per affrontare alcune criticità della guida autonoma: eventi rari, imprevedibili, spesso causa di disattivazioni o errori dei sistemi.

A differenza dei sistemi tradizionali, Alpamayo non si limita a individuare ostacoli e pianificare una traiettoria. Utilizza un approccio di chain-of-thought reasoning (CoT), elaborando flussi video e producendo non solo la decisione di guida, ma anche la logica che la giustifica.

Un aspetto cruciale in ottica di sicurezza funzionale, validazione e – guardando all’Europa – conformità regolatoria.

Open-source come leva industriale

La scelta di NVIDIA di rendere open-source gran parte dell’ecosistema è tutt’altro che marginale. L’obiettivo dell’azienda è chiaro: diventare l’“Android della guida autonoma”, in contrapposizione a soluzioni chiuse come Tesla FSD.

Per costruttori e fornitori europei, questo approccio potrebbe tradursi in maggiore trasparenza, possibilità di audit del software e adattamento ai requisiti UNECE, elementi spesso critici per l’omologazione.

Mercedes-Benz CLA, primo banco di prova

La Mercedes-Benz CLA model year 2025 sarà la prima vettura di serie a integrare l’intero stack NVIDIA con Alpamayo. L’auto tedesca andrà sul mercato statunitense nel primo trimestre di quest’anno. A seguire Europa e Asia.

Il sistema debutterà come Livello 2+, quindi con attenzione costante del conducente, in linea con quanto già visto sul mercato. L’ambizione dichiarata, però, è un’evoluzione progressiva verso funzionalità di livello superiore, potenzialmente fino al Livello 4, laddove normative e infrastrutture lo consentiranno.

Interessante la dotazione sensoriale: 30 sensori complessivi, con 10 telecamere, 5 radar e 12 ultrasuoni. Una scelta che riflette l’approccio prudente tipico dei costruttori premium europei, ancora poco inclini a puntare su una singola tecnologia.

Digitale & batterie: se qualcosa va storto nei “software defined vehicle”…

Vera Rubin, il motore invisibile dell’AI

Dietro Alpamayo c’è Vera Rubin, la nuova piattaforma NVIDIA a 6 chip che succede a Blackwell. Pensata soprattutto per data center, è qui che avviene l’addestramento massivo e la simulazione su larga scala. Le GPU “Rubin” e le CPU “Vera” saranno decisive per le iterazioni future del software che, una volta validate, arriveranno anche sulle auto di serie.

- LEGGI anche “Tesla Full Self-Driving in Italia: la nostra prova su strada rivela come funziona davvero” e guarda il VIDEO

E’ un tema estremamente interessante, perché di fatto sancisce la supremazia Tesla (in questo momento, ovviamente, per il futuro si vedrà):

– implicitamente riconosce che l’approccio di Tesla con FSD V12 (e ora siamo a V14) basato su reti neuronali e non algoritmi precodificati era corretto;

– assegna a Tesla un primato che, sempre al momento perchè Xiaomi è dietro l’angolo, nessun europeo può vantare: milioni di veicoli che inviano dati per l’addestramento su casi reali.

Perché la partita si gioca sull’eccezione, non sulle regole: cito una frase di Iron Man, quando Tony Stark affronta il suo ex socio all’interno del robot che lo sta portando in quota stratosferica “Tu come hai risolto il problema del ghiaccio?” giusto qualche istante prima di vederlo precipitare senza controllo.

Il 99% delle situazioni sono gestibili e le affronti in un anno di sviluppo, il restante 1% richiede anni e anni di eccezioni (un esempio: ad Halloween, quando ti attraversa la strada un tizio vestito da cassetta postale o da Oca dalle uova d’oro gigante, come la interpreta una AI?)

E qui, con oltre 4 milioni di auto con HW4 che costantemente “simulano” di guidare con FSD anche se sono sotto il controllo umano e mandano a Tesla il dataset delle differenze, chi può batterli? (Xiaomi, Xpeng e BYD a parte che per volumi, regole sulle privacy e potenza economica possono fare la stessa cosa, manca ancora poco).

Per gli europei la vedo sempre più dura…

… e niente LiDAR! Diventa sempre più dura per chi ne sosteneva l’assoluta necessità.